課程介紹

過去十年來,自然語言處理(NLP)的應用已呈現爆炸性成長。隨著 AI 助理數量激增,公司組織也在業務中融入更多互動式人機體驗,因此勢必得理解自然語言處理技術是如何用於處理、分析和產生文字型態資料。深度學習模型已受到自然語言處理廣泛採用,其中以 Transformer 為基礎的模型,例如 Transformer 的雙向編碼表示法(BERT),在 SQuAD 的問答系統、實體識別、意圖識別、情緒分析這類基準上,所提供的準確度與人類標準相差無幾,讓 NLP 的發展發生了革命性的劇變。 在設計正確的情況下,開發人員可以運用這些技術打造強大的自然語言處理應用程式,在聊天機器人、人工智慧語音助理及更多其他的應用程式上,提供自然且順暢的人機互動效果。

在本課程中,會學習如何將以 Transformer 為基礎的自然語言處理模型運用於文字分類工作,例如分類文件。也會學到如何利用以 Transformer 為基礎的模型來處理命名實體識別(named-entity recognition,NER)工作,以及如何分析各種模型功能、限制和特性,以便依據指標、領域獨特性和可用資源,判斷何種模型最適合特定使用案例。

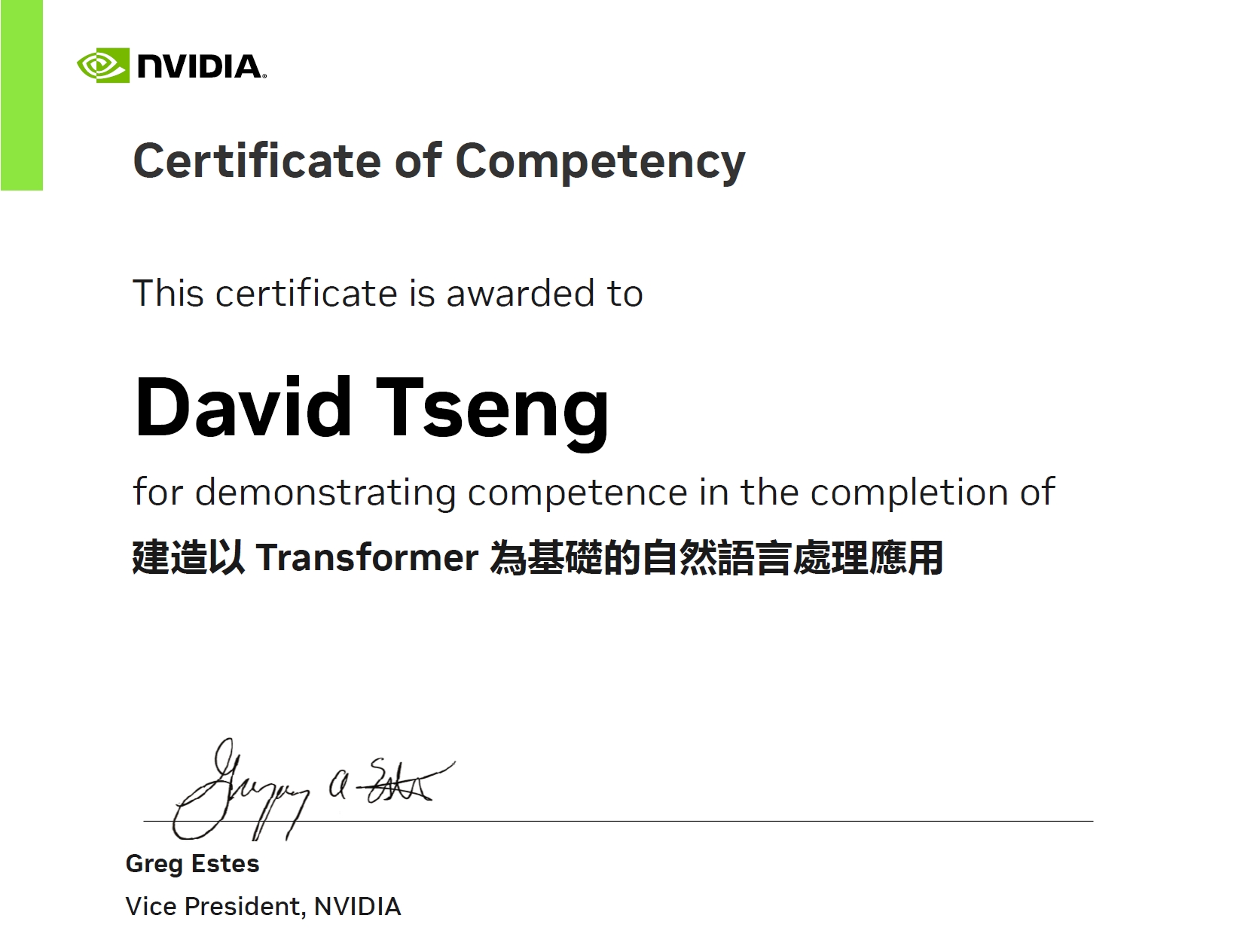

本課程原文名稱為 [Building Transformer-Based Natural Language Processing Applications],由 NVIDIA DLI 提供正體中文版本,相關資訊皆以原廠為準。

完成課程評量之後即可取得完課證明。

課程定位

- 程度:技術 – 中級 (本課程屬於 NVIDIA DLI / LLM grouping Level 1 )

- 主題:深度學習 / 生成式AI / 大語言模型

- 完課證明:有

- 考試方式:程式實作

- 課程先修條件:熟悉 Python 語法,對於 LLM 關鍵技術有扎實理解

- 所需軟體:Python3 / NVIDIA NIM / BERT 模型

- 所需硬體:可連上網際網路的筆記型電腦,用於連入 DLI 雲端虛擬機執行課程,筆記型電腦無須另外安裝程式

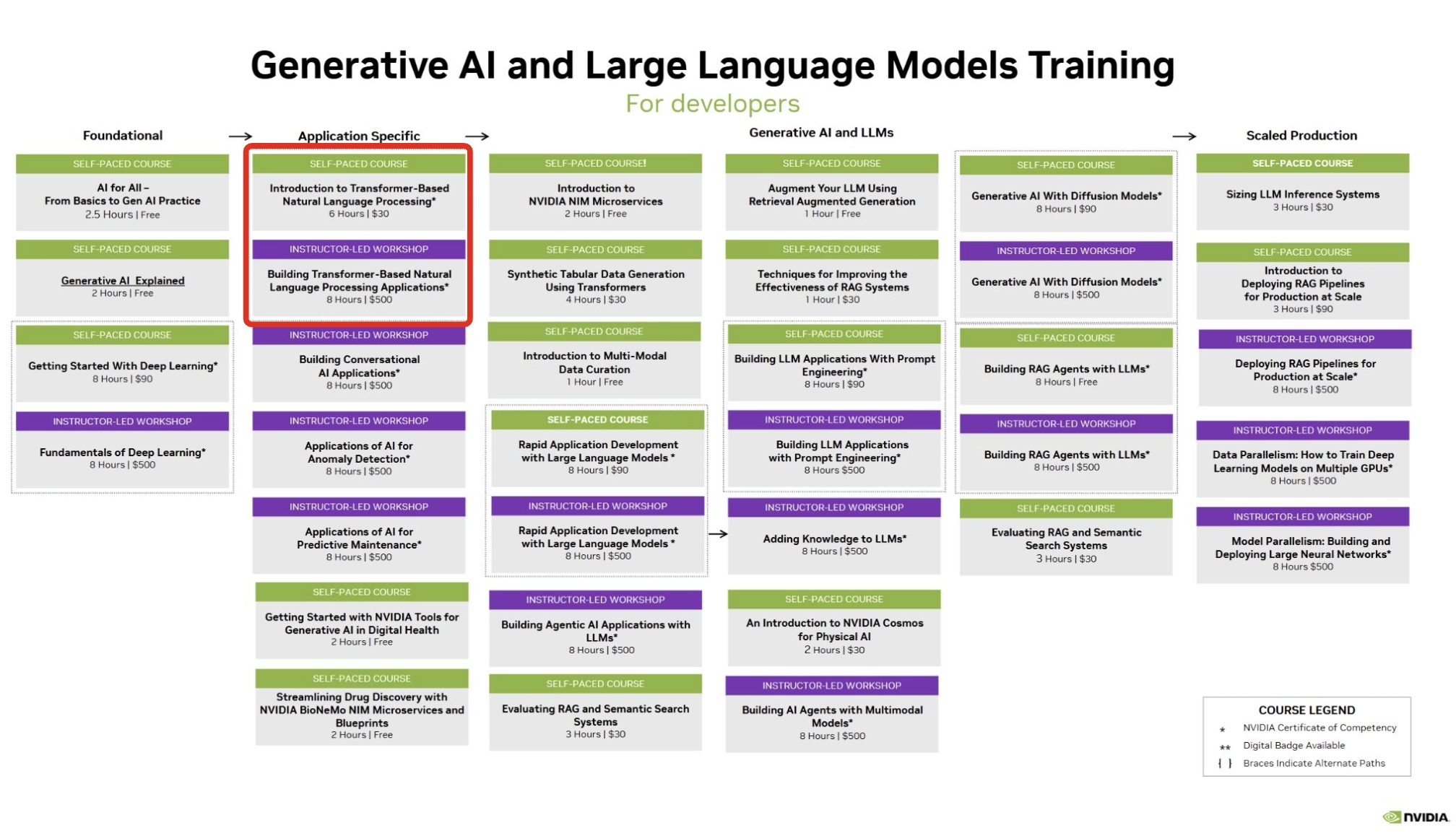

- 相關資訊:請參考 DLI Generative AI / LLM 學習路徑

- 課程定位:本課程位於 DLI 學習路徑之 Generative AI / LLM分類,如下圖,也歡迎從中找到更多您喜歡的課程:

學習目標

完成本課程後,您將能夠:

- 瞭解文字內嵌如何在自然語言處理工作中迅速進化,例如Word2Vec、遞歸神經網路(RNN)型內嵌及 Transformer

- 瞭解 Transformer 架構功能(尤其是自注意力機制)是如何用於建立語言模型,而無需遞歸神經網路

- 使用自我監督技術提升 BERT、Megatron 和其他變體中的 Transformer 架構,以達到優異的自然語言處理成果

- 利用預先訓練的現代自然語言處理模型處理多項工作,例如文字分類、命名實體識別和問答系統

- 管理推論階段的各種難點,並部署即時應用程式的微調模型

課程特色

1. 完整學習路徑,涵蓋 NLP 核心技術

課程從文字內嵌 (Word2Vec、RNN embeddings、Transformer) 演進開始,深入到自我注意力機制 (Self-Attention)、BERT 與 Megatron 等模型,幫助學員全面理解現代 NLP 的核心技術。

2. 實作導向,動手打造 NLP 應用

透過 PyTorch 與 NVIDIA NeMo,學員將親手完成文字分類、命名實體識別 (NER)、翻譯等專案,從基礎原理到實際應用,確保理論與實作並重。

3. 強調部署與效能最佳化

不僅停留在模型訓練,課程還指導如何使用 NVIDIA Triton Inference Server 與 TensorRT,將模型最佳化並部署於即時應用,具備落地到產業應用的完整能力。

4 原廠完課證明,助力專業發展蓋最新技術與工具

完成實作與測驗後,學員可獲得 NVIDIA DLI 的完課證明,為履歷與專業職涯增添具公信力的國際認可。

5. 雲端 GPU 環境,降低學習門檻

課程提供雲端 GPU 加速環境,學員只需使用瀏覽器即可進行所有實驗,不必自行安裝或設定,專注於學習與實作。

課表

第一天

| 時間 | 內容 |

| 10:00 – 10:30 | 簡介NVIDIA DLI深度學習機構與主流AI工具

註冊NVIDIA開發者帳號 Transformer 簡介:探索 Transformer 架構與核心應用。 |

| 10:30 – 12:00 | 實作:Transformer in PyTorch:建立 Transformer 架構;計算自注意力矩陣。

應用實例:使用預訓練模型將英文翻譯為德文。 |

| 12:00 – 13:00 | 午餐時間 |

| 13:00 – 14:40 | 自監督學習與 BERT 基礎

深入了解自監督 Transformer 模型與 BERT。 |

| 14:40 – 15:00 | 休息與交流時間 |

| 15:00 – 16:30 | 專案實作:文字分類:利用 NVIDIA NeMo 建立摘要分類專案。 |

| 16:50 – 17:00 | Q&A 與複習:

回顧本日學習內容並解答問題。 |

第二天

| 時間 | 內容 |

| 10:00 – 11:00 | NER 專案實作

建立實體辨識 (NER) 專案,辨識文本中的疾病名稱,並提升準確性。 |

| 11:00 – 12:00 | 模型部署準備:

使用 NVIDIA® TensorRT™ 進行模型最佳化,探討部署考量。 |

| 12:00 – 13:00 | 午餐時間 |

| 13:00 – 15:20 | NVIDIA Triton 簡介:學習如何將模型部署於即時推論環境中。

部署實作:使用 NVIDIA Triton 部署模型,並測試即時推論環境。 |

| 15:20 – 15:30 | 休息與交流時間 |

| 15:30 – 16:30 | 課程評量

– 完成課程評量並獲得證書。 |

| 16:30 – 17:00 | 結尾與後續資源:

填寫課程問卷,了解環境設置與進階學習資源。 |