課程介紹

隨著大型語言模型(LLM)展現出卓越的能力,企業積極將其整合至產品與內部應用中,以滿足各種使用場景,包括(但不限於)文字生成、大規模文件分析及聊天機器人助手。

運用現代提示工程(Prompt Engineering)技術是最快速的方法來利用 LLM 處理多樣化任務。這些技術也是更高級的 LLM 方法(如檢索增強生成 Retrieval-Augmented Generation,RAG)與參數高效微調(Parameter-Efficient Fine-Tuning,PEFT)的基礎。

在本工作坊中,學員將使用 NVIDIA NIM 評台搭配 Llama-3.1 大型語言模型,並結合熱門的 LangChain 函式庫來打造各種 LLM 應用。您將可實際體驗提示工程確實可有效提升 LLM 的生成品質。

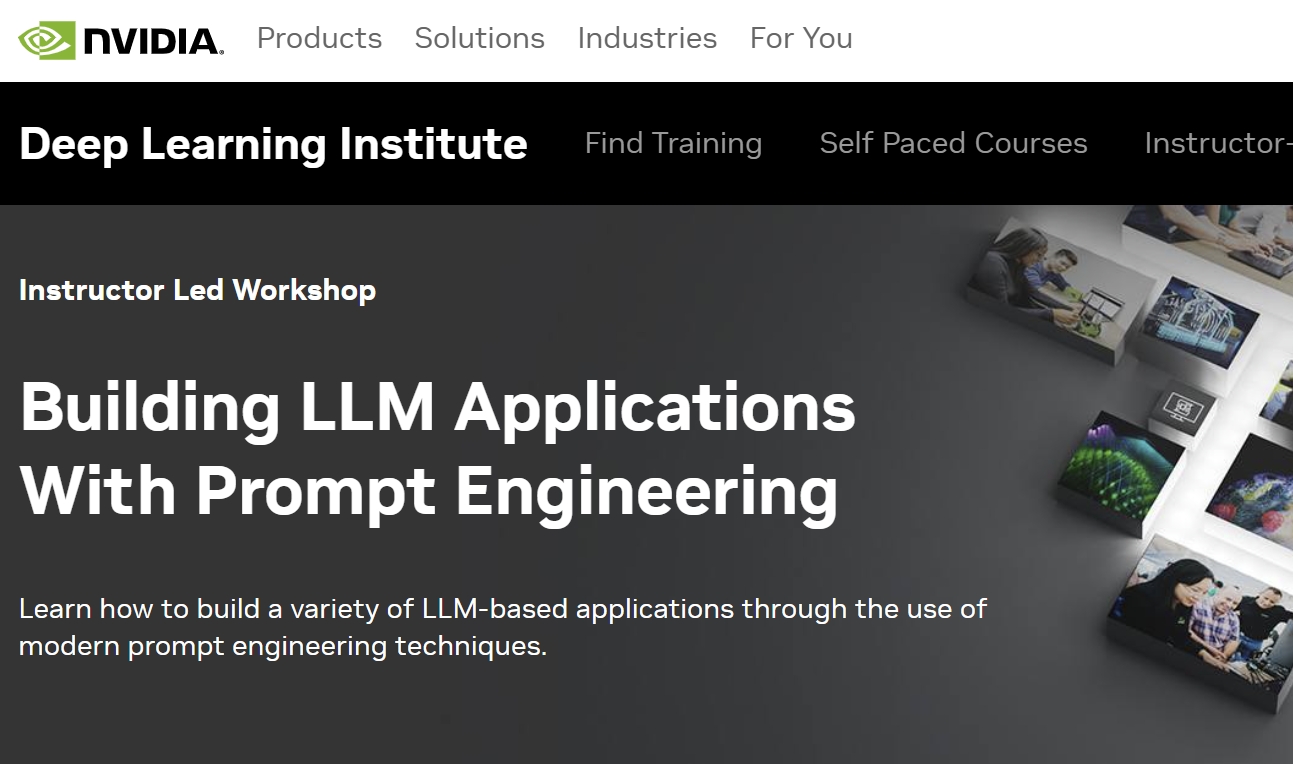

本課程原文名稱為 [Building LLM Applications With Prompt Engineering],NVIDIA DLI 目前未提供正體中文版本,相關資訊皆以原廠為準。

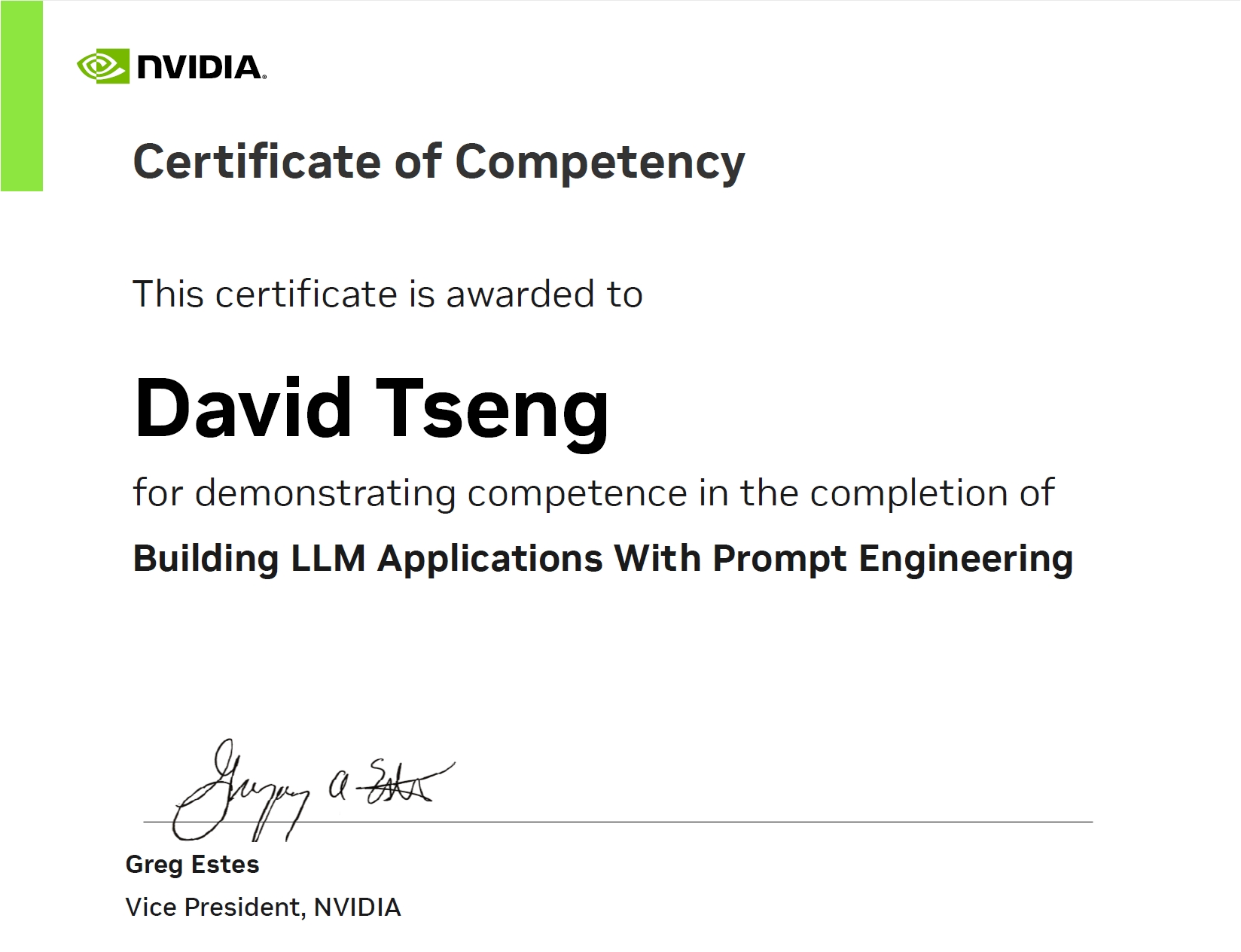

完成課程評量之後即可取得完課證明。

課程定位

- 程度:技術 – 中級 (本課程屬於 NVIDIA DLI / LLM grouping Level 1 )

- 主題:深度學習 / 生成式AI / 大語言模型

- 完課證明:有

- 考試方式:程式實作

- 課程先修條件:熟悉 Python 語法,對於 LLM 關鍵技術有扎實理解

- 所需軟體:Python3 / NVIDIA NIM / LangChain

- 所需硬體:可連上網際網路的筆記型電腦,用於連入 DLI 雲端虛擬機執行課程,筆記型電腦無須另外安裝程式

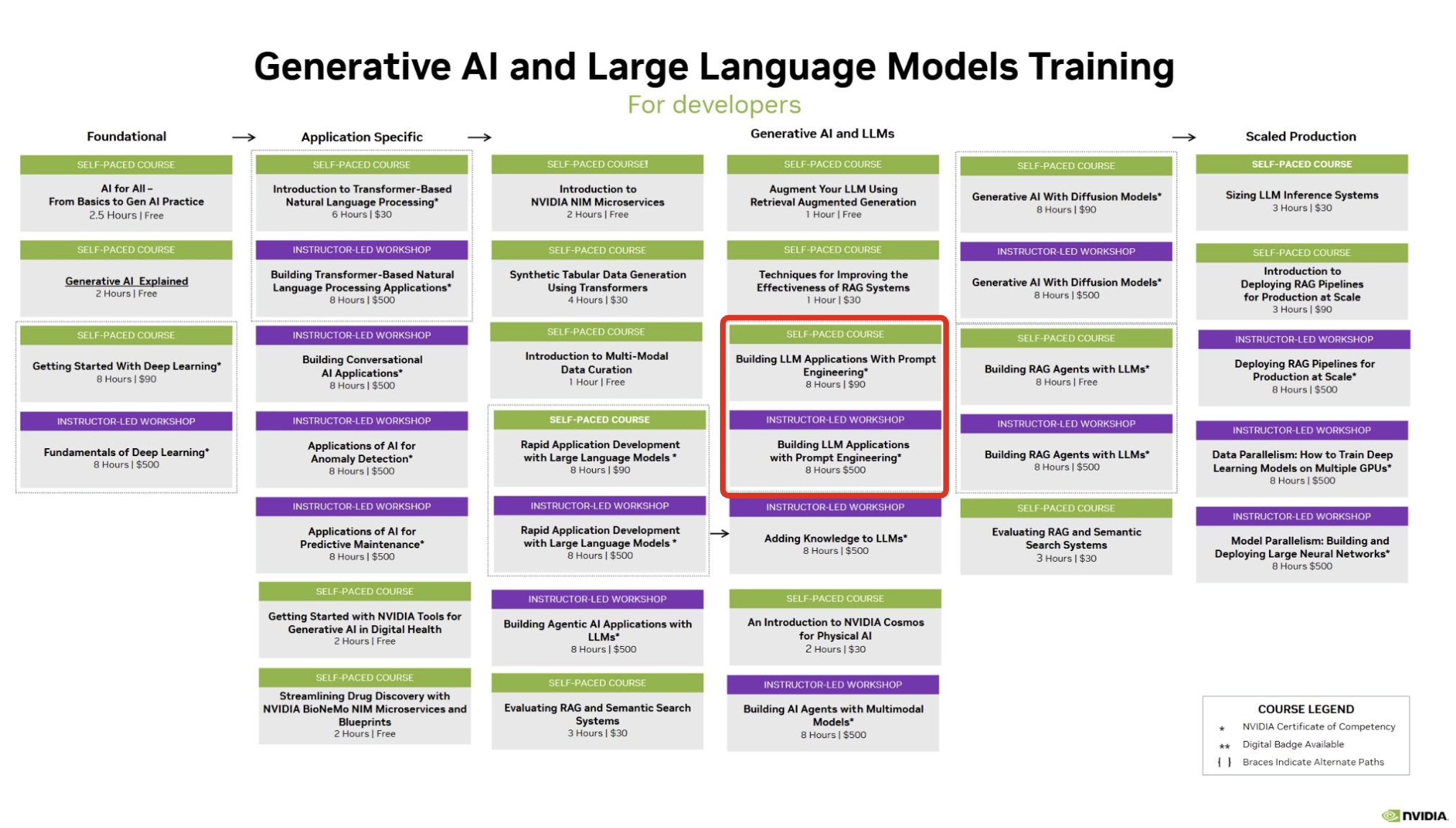

- 相關資訊:請參考 DLI Generative AI / LLM 學習路徑

- 課程定位:本課程位於 DLI 學習路徑之 Generative AI / LLM分類,如下圖,也歡迎從中找到更多您喜歡的課程:

學習目標

完成本課程後,您將能夠:

- 理解如何應用迭代式提示工程的最佳實踐,以開發各種語言相關任務的 LLM 應用程式。

- 熟練使用 LangChain 來組織和建構LLM工作流程。

- 開發應用程式,得以妥善運用 LLM 進行生成任務、文件分析、聊天機器人應用等。

課程特色

1. 全面涵蓋 LLM 開發與應用

本課程從 Transformer 基礎概念開始,逐步進入大型語言模型(LLM)應用開發,最終涵蓋智能代理與模型編排,提供完整的學習路徑。

2. 實作導向的學習體驗

透過 Hugging Face 模型庫、Transformers API 及 LangChain,學員將實際操作 LLM 來進行文字生成、問答系統、分類及多模態應用開發。

3. 企業應用場景驅動

課程探討 LLM 在企業環境中的應用,如 AI 客服助手、情感分析、機器翻譯及可擴展的文本生成,幫助企業提升運營效率與服務品質。

4 涵蓋最新技術與工具

學習檢索增強生成(RAG)、Parameter-Efficient Fine-Tuning(PEFT)、多模態模型(CLIP、Diffusion)、LangChain 及 LangGraph,掌握最新的 LLM 技術趨勢。

5. 課程認證與實作評量

透過最終評估,學員需整合文字生成、多模態學習與智能代理技術開發 LLM 應用,完成課程後將獲得結業證書,驗證所學技能。

課表

第一天

| 時間 | 內容 |

| 10:00 – 10:30 | 簡介NVIDIA DLI深度學習機構與主流AI工具

註冊NVIDIA開發者帳號 介紹 NVIDIA NIM,用於部署本課程中使用的 Llama 3.1 LLM。 |

| 10:30 – 12:00 | 認識提示設計

– 理解提示工程與LLM之間的緊密關係。 – 使用 OpenAI API 和 LangChain 建立提示並檢視其回應結果。 – 學習如何串流 LLM 回應,並以批次方式發送提示,比較不同的效能表現。 – 練習迭代式提示開發(Iterative Prompt Development)過程。 – 建立並使用第一個提示模板(Prompt Templates)。 – 進行一個迷你專案,對一批輸入執行分析與生成任務的組合操作。 |

| 12:00 – 13:00 | 午餐時間 |

| 13:00 – 14:40 | LangChain 表達式語言(LCEL)、Runnables 與 Chains

– 學習 LangChain Runnables,以及如何使用 LangChain Expression Language(LCEL) 來組合這些運行單元(Runnables)形成鏈(Chains)。 – 撰寫自訂函式,並將其轉換為 Runnables,以納入 LangChain Chains 中。 – 將多個 LCEL Chains 組合成一個更大的應用程式鏈(Application Chain)。 – 以平行(Parallel)方式執行 LCEL Chains 來提升效率。 – 進行一個迷你專案,使用 LCEL 和平行執行來對一批輸入執行分析與生成任務的組合操作。 |

| 14:40 – 15:00 | 休息與交流時間 |

| 15:00 – 16:50 | 使用訊息進行提示設計

– 學習兩種核心的聊天訊息類型:人類訊息(Human Messages)和AI 訊息(AI Messages),並了解如何在應用程式中明確使用它們。 – 透過少樣本提示(Few-Shot Prompting)技術,為聊天模型提供指導性範例,以提高回應品質。 – 明確使用系統訊息(System Message),讓聊天模型具備特定的角色和個性設定。 – 運用思維鏈提示(Chain-of-Thought Prompting),增強 LLM 執行複雜推理任務的能力。 – 管理聊天訊息,以保留對話歷史,並實現聊天機器人的功能。 – 進行迷你專案,打造一個靈活的多角色聊天機器人應用。 |

| 16:50 – 17:00 | 結語、賦歸 |

第二天

| 時間 | 內容 |

| 10:00 – 11:00 | 結構化輸出

– 探索使用 LLM 批次生成結構化資料的方法,以便於後續應用。 – 結合 Pydantic 類別與 LangChain 的 JsonOutputParser 來生成結構化輸出。 – 學習如何從長篇文字中提取資料,並依照需求進行標註。 – 完成一個迷你專案:利用結構化資料生成技術,從非結構化文字文件中進行資料擷取與文件標註。 |

| 11:00 – 12:00 | 擴充文字生成規模

– 運用提示工程技術讓 LLM 生成不同長度、風格與格式的文字。 |

| 12:00 – 13:00 | 午餐時間 |

| 13:00 – 15:20 | 工具使用與智能代理

– 建立 LLM 外部功能(Tools),讓LLM能夠辨識並呼叫這些工具。 – 開發智能代理(Agent),使其能夠判斷何時應該使用工具,並將工具的結果整合進 LLM 的回應。 – 進行迷你專案,開發一個可呼叫外部 API 的 LLM 代理,使其能夠增強回應內容並提供即時資料。 |

| 15:20 – 15:30 | 休息與交流時間 |

| 15:30 – 16:30 | 課程評量

– 完成課程評量並獲得證書。 |

| 16:00 – 17:00 | 結尾與後續資源:

填寫課程問卷,了解環境設置與進階學習資源。 |